Center Loss

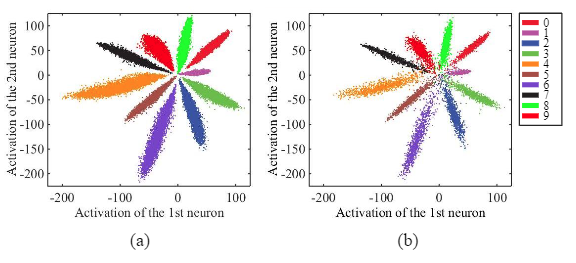

对于常见的图像分类问题,我们通常使用交叉熵损失函数监督神经网络。下图为神经网络在MNIST数据集上进行手写体数字分类任务得到的特征分布,在类与类之间能看到很明显的界限,能够便于softmax对特征进行分类。但是仍然可以看出部分不同类的样本距离很近,而同类的样本分布距离较远,这有可能对最终的分类结果有影响。

而Center Loss的提出就是为了缩小类内(intra-class)距离。其公式表示如下:

其中$c_{yi}$表示第y个类别的特征中心,$x_i$表示全连接层之前的特征,$m$表示mini-batch的大小。该损失函数试图使每个样本的特征向其类别中心靠近。

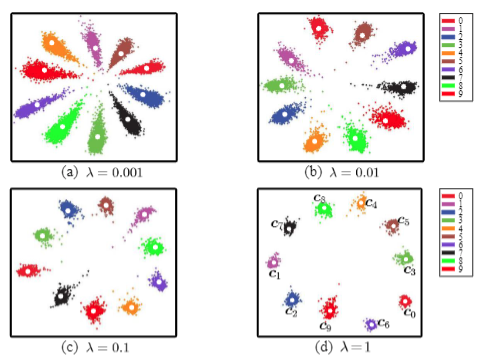

至于类中心怎么更新迭代,这里就不写了(公式太复杂了yingyingying)。反正最终得到的特征分布如下: